生成AIを仕事で活用する場合、頭に入れておくべきリスクがあります。正しい使い方をしないと、自らが被害者あるいは権利を侵害する加害者になる可能性もゼロではないのです。特に企業が生成AIを導入する際は、リスクを考慮したうえで活用方法を検討するべきです。大きな過ちをすると、企業全体に多大な影響を及ぼし、社会的信頼を失いかねません。

本記事では、生成AIをめぐるリスクの実例を参考にしながら、どうすればリスクを避けることができるのか、解説します。

生成aiのリスクの事例

生成AIによって企業が被害を受けた事例や、大きなトラブルに発展した事例をいくつか紹介していきましょう。

1つ目は、ディープフェイクによる詐欺被害です。イギリスのエネルギー企業でCEOを務める人物が、ドイツにある親会社のCEOから電話連絡を受け、「緊急で22万ユーロ(約2600万円)をハンガリーのサプライヤーに送金して欲しい」と頼まれました。

同者は指示通りに送金しましたが、実はAI音声技術で親会社のCEOに近い声を作り上げた詐欺師からの連絡だったのです。詐欺師は再び送金を要求するために電話をかけましたが、電話の発信源がドイツではなくオーストリアであることに気付き、イギリス企業のCEOは詐欺だと認識したそうです。

同様のケースで、香港の多国籍企業の財務担当者が、ビデオ通話に騙されて38億円を送金する大規模な詐欺事件も発生しました。財務担当者が参加したテレビ会議は、映像と音声いずれもAIによって複製されたディープフェイクでした。社員の映像ないし写真と音声データがあれば、偽物のテレビ会議で相手を騙せることが判明した恐ろしい事例です。

2つ目は、社内の機密情報が漏洩したトラブルです。韓国のサムスン電子では、エンジニアが社内ソースコードを誤ってChatGPTにアップロードした結果、重要なデータが他のユーザーに公開されてしまいました。サムスン電子は、従業員がchatGPTなどの生成AIツールを利用することを禁止する規約を策定しています。厳密には、社内ネットワーク上での利用を禁止し、個人のタブレットやスマートフォンにおける利用は制限していません。ただし、機密情報や知的財産、個人データなどを入力しないよう強く要請されているそうです。

生成aiに学習させないためには?

生成AIに社内の重要なデータや個人情報を学習させると、情報漏洩のリスクにつながります。それでは、生成AIを安全に利用するにはどうしたらいいのでしょうか。

最も効果的な対策としては、オプトアウト設定を欠かせないことです。大規模言語モデルの生成AIであるchatGPTには、オプトアウトという機能が備わっています。この機能は、簡単にいうと自分が入力した情報を学習データの対象から除外でき、不特定多数のユーザーに情報が公開されるリスクを避けることができます。

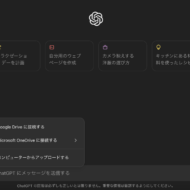

では、chatGPTにおけるオプトアウト設定の手順を解説します。

①アイコンから「設定」を選択する

②「データコントロール」をクリックして、「すべての人のためにモデルを改善する」を開く

③ボタンをスライドして、“すべての人のためにモデルを改善する”をオフにする

④「実行する」をクリックする

上記とは別に、chatGPTを運営するOpenAI社に、プライバシーリクエストを提出する方法もあります。

①OpenAIの申請フォームにアクセスする

②「Make a Privacy Request」をクリックする

③「I have a ChatGPT account」を選択する

④「Do not train on my content」を選ぶ

⑤chatGPTのアカウント登録で用いたメールアドレスを入力し、「Send Email」をクリックする

⑥受信したメールを開いてログインする

⑦表示されたページで、自分の居住国を選択し、「Confirm Request」をクリックする

➇オプトアウト設定完了のメールが届く

ブラウザからオプトアウト設定するより手間がかかるものの、情報管理を徹底する場合は、OpenAI社の申請フォームから手続きを行うといいでしょう。

ai学習禁止!透かしのやり方を解説

アーティストが制作した画像が、生成AIの学習素材として使用されることを避ける対策が広まっています。その一つが「透かし」という方法です。透かし(ウォーターマーク)とは、画像の上に文字情報を表示することです。自身のサインや権利情報、無断転載NGやAI学習禁止などの文言を、画像に重ねて載せると盗用防止にもつながります。

画像生成AIは、ネット上にある画像データを無断で学習素材にします。そういった現状を重く受け止め、アーティストたちの間で透かしを共有する動きも出始めました。よって、必ずしも自分で透かしを作成する必要はなく、透かし素材を配布しているサイトを探してみてください。

透かしの効果について、画像生成AIは文字も情報の一部として認識し、正確な画像データを学習する妨げになるわけです。また、透かしが入った画像をもとに出力した画像に、同じ透かし文言が表示される事例も確認されています。これだと、すぐにパクりイラストだと気付きますよね。

学習禁止を重点に置いて透かしを載せるなら、メインキャラクターに自身のサインやコピーライト表記、禁止文言を被せるといいでしょう。作品の見栄えが悪くなる難点は否定できないものの、AI対策として致し方ないところです。オリジナルの柄や模様を背景全面に表示するのも有効です。

注意点として、画像生成AIは日々進化しており、透かし情報を取り除いて学習したり、透かし除去の学習素材として利用されるケースも散見されます。同じ透かしを使い続けるのではなく、定期的に新しいものに替えたり、より複雑な仕様に変更する必要はあるでしょう。

まとめ

生成AIは多くのデータ・情報を学習してこそ性能が高まる仕組みです。ユーザー側がアクションを起こさないと、入力情報は自動的に学習素材となっていきます。chatGPTのようなテキスト生成AIでは、機密情報の漏洩や個人情報の流出リスクが高いです。一方、画像生成AIはアーティストの作品と酷似したコンテンツが作られるなど、著作権の侵害が大きな課題です。

クリエイターが対策を講じても、生成AIの進化スピードが速く対応が追いつかないケースも出てきました。こうした問題に関しては、法の整備が必要なフェーズに突入したのかもしれません。