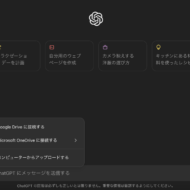

chatGPTは作業効率を向上させ、新たなアイディアを得るなどの役割を果たすことができるため、ビジネスシーンでも多用されています。一方で、AI学習によって情報漏洩が起こるのではないかという懸念を抱えている企業があるのも事実です。

そこで、この記事を通して、chatGPTを使うことで起こり得る情報漏洩リスクの実際を紹介すると共に、どのようにしたら問題を防止できるのかを解説していきます。

chatGPTで起こり得る情報漏洩のリスク

chatGPTを使うことで、企業が持つ情報の漏洩が起こるリスクがあるのは事実です。そもそも、chatGPTのようなAIサービスは、ユーザーもしくは世界中で公開されているデータを学習データベースに取り込んで、機械学習させることで成り立っています。そのため、chatGPT上に入力した情報がシステムのデータベースに取り込まれてしまうことがあるわけです。もし、こうした形で顧客や取引先に関する個人情報を入れたり、会社の機密情報を入力したりすると、情報漏洩につながる恐れがあるのです。

もちろん、chatGPTを提供しているOpenAIでは徹底した情報管理制度を持っていますし、厳密な情報保護に関するポリシーを持っています。それでも、ヒューマンエラーが起こることは当然予測しておくべきですし、悪意のある第三者が何らかの形でサイバー攻撃を仕掛けるなどして、システムに侵入する恐れもゼロとは言えません。そのため、利用する企業側としても、ある程度のリスクを事前に予測して、それに応じた対策を講じておくべきでしょう。

実際に、chatGPTを使うことで情報漏洩が生じたと考えられるケースがいくつか生じています。有名なところでは、2023年にサムスン電子で起こったケースです。自社で開発しているプログラムに関するソースコードをchatGPT上で入力したり、社内会議の発言内容を入れたりしたといったインシデントが報告されています。これが外部に流出したという形跡はありませんが、少なくても社内の重要な情報をchatGPTという社外システムに保存されたことは、一種の情報漏洩になると判断されています。

また、chatGPT自体のバグが生じたケースも報告されています。あるユーザーがchatGPTを使用していると、別の利用者が入力したと思われる履歴の表題が表示されていることに気付きました。入力内容の本文自体が見られることはありませんでしたが、chatGPTのシステムのバグによって他者の履歴が見られるようになっていたことも、見逃せない問題と言えるでしょう。

今まで、大規模かつ大きな影響を与える情報漏洩が起きたという報告はされていません。しかし、社員の使い方やちょっとしたエラーによって、情報漏洩の生じるリスクがあることは理解できます。

chatGPTで情報漏洩はなぜ起こる?

chatGPTを利用することで起こる情報漏洩には、いくつかの原因が考えられます。一番の懸念点となっているのが、ユーザーが入力したデータがすべてOpenAIのデータベースに保存され、学習されているということです。もちろん、OpenAIではこうした情報を学習以外の目的で使用することはなく、外部へ提供することは決してないとしています。しかし、サムスン電子の例にあるように、たとえそれが悪用されないとしても、企業内にのみ留めておくべき情報をOpenAIという他社に漏らしてしまう恐れは十分あるのです。chatGPTは気軽に、さまざまな目的で使えるので、社員が容易な気持ちで重要情報を入力してしまう可能性を考えておくべきでしょう。

また、chatGPT自体の問題も考えられます。システムバグによってデータが見られる状況になることは起こり得ますし、chatGPTとの通信ルートやchatGPTのデータベースに不正アクセスされることで膨大なデータが盗まれることもあり得ます。

別の問題としては、chatGPTのアカウント情報を盗まれるという点も考えるべきです。このサービスでは、メールアドレスとパスワードによってアカウントにログインできる仕組みとなっています。それが他者に知られると、勝手にアカウントに入られてしまう恐れがあります。そうなると、過去に入力した内容をチェックできますので、そのデータをコピーして流出させることも可能です。社員のパスワード管理が甘いことによっても起こり得るわけです。

chatGPT利用での情報漏洩を防ぐ方法とは?

企業内でこうした情報漏洩を防ぐ方法として、まず利用に関するガイドラインを作るべきでしょう。利用に当たって、どの程度の情報までを入力して良いのか、使って良いデバイスは何か、使用するアカウントの種類などを決めて、全社的に統一して運用させます。

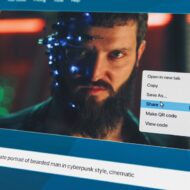

そのルールの例としては、個人アカウントでは業務に関する入力はしない、公開度の高いブラウザ版で機微な情報は入れないといった制限が考えられます。また、「Chat history&Training」機能を設定の段階でオフにするという対策も重要です。この機能をオフにすることによって、履歴を残さずに済みますし、入力したデータをAI学習のための保存させることができなくなります。特に、機密情報を入れる必要がある場合にはこの設定をオフにしておかないと、学習のためにデータが保存されることになりますので、要注意です。

また、APIバージョンもしくはEnterpriseプランを利用することも会社として検討すると良いでしょう。こうしたプランは、一般公開型のサービスよりもさらにセキュリティーに配慮したサービスを提供しています。たとえば、入力したデータをAI学習に使わず、入力データは暗号化されて通信し、サイバーセキュリティ対策の充実が図られているといった利点があります。入力履歴が保護され、機密情報の入力もできることになるので、多様な使い方を可能とします。よりchatGPTを業務の中で活用していきたいと考えているのであれば、これらのプランを検討してみましょう。

セキュリティーシステムを活用するのも一つの手です。たとえば、DLPというシステムを導入すると、指定した条件に関わる機密情報が入力された場合、自動的に送信やコピーなどがブロックされます。また、Microsoftの「Azure OpenAI Service」というシステムも、アクセス制限やデータの保護などの対策を提供していますので、活用するメリットが大きいでしょう。chatGPTの機能をより効果的に利用するサービスもあり、使い勝手が良いシステムでもあります。

リスクを理解した上でchatGPTを利用するべき

chatGPTの利用については、OpenAIに機密情報を入れてしまう、ユーザーアカウントを盗用される、システムエラーなどによって、情報漏洩が起こるリスクが考えられます。そのため、社内で統一したルールを作り、リスクを理解した上で安全に利用できる方法を採るべきです。こうすることで、利便性の高いchatGPTを安心して活用できるでしょう。